Fiume, dicembre 2024 – Alla seconda conferenza internazionale sull'insegnamento e l'apprendimento nell'educazione medica (MEDRI 2025 – FUTUREMED), organizzata dalla facoltà di medicina dell'Università di Fiume, Damir Medved, direttore di EDIH ADRIA, ha presentato un'analisi completa delle implicazioni tecnologiche, etiche e giuridiche dell'uso di agenti di conversione dell'IA nell'assistenza sanitaria.

Rivoluzione con sfide

La lezione è iniziata con una domanda fondamentale che definisce l'intero problema dell'implementazione dell'intelligenza artificiale in medicina: "Dove si trova il confine tra le informazioni generali che un agente dell'IA può fornire adeguatamente e i settori che richiedono competenze professionali?" A dimostrazione dell'importanza di questo problema, Medved ha sottolineato che la configurazione errata dell'auto comporta perdite finanziarie, mentre la consulenza medica errata può avere gravi conseguenze per la salute.

L'esperienza del progetto EDIH ADRIA, classificato tra i primi 5% tra 225 poli europei dell'innovazione digitale per prodotto, indica che 92,3% i servizi forniti hanno una componente di IA nei servizi forniti. Questi dati evidenziano l'incredibile opportunità che gli agenti di conversione dell'IA offrono per trasformare il coinvolgimento dei pazienti, l'efficienza amministrativa e il supporto clinico, ma allo stesso tempo rivelano anche sfide significative che richiedono un'attenta considerazione.

Il panorama normativo in fase di definizione

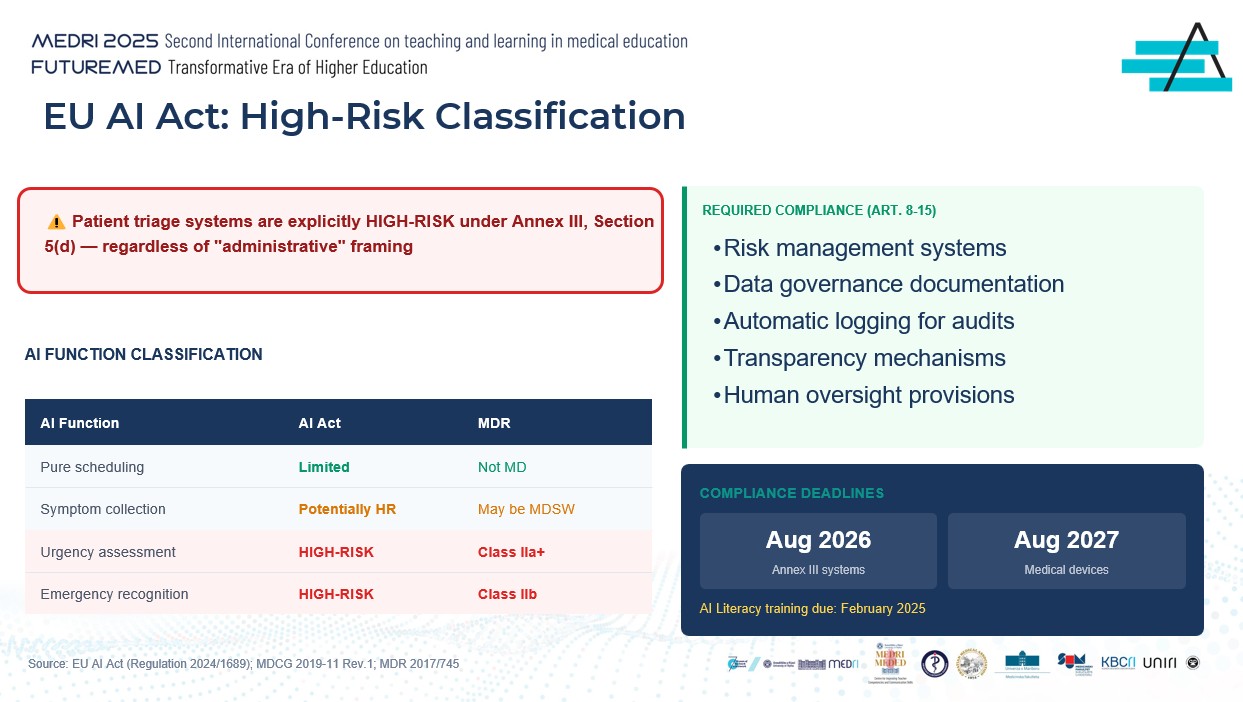

Una delle questioni centrali della ricerca presentata riguarda la classificazione normativa dei sistemi di IA nell'assistenza sanitaria. Ai sensi della nuova legge dell'UE sull'IA (regolamento (UE) 2024/1689), i sistemi di triage dei pazienti sono esplicitamente classificati come ad alto rischio ai sensi dell'allegato III, sezione 5, lettera d), indipendentemente da qualsiasi inquadramento "amministrativo". Tale classificazione comporta una serie di requisiti di conformità, tra cui i sistemi di gestione del rischio, la documentazione sulla gestione dei dati, la registrazione automatica per gli audit, i meccanismi di trasparenza e le disposizioni in materia di sorveglianza umana.

Medved ha elaborato in dettaglio i diversi livelli di classificazione delle funzioni di IA. Mentre gli appuntamenti puri sono classificati come a rischio limitato e non sono dispositivi medici, la raccolta dei sintomi è potenzialmente ad alto rischio e può essere classificata come software medico. La valutazione dell'urgenza e il riconoscimento delle emergenze rientrano inequivocabilmente nella categoria ad alto rischio e richiedono la classificazione come dispositivi medici delle classi IIa+ e IIb, rispettivamente, ai sensi del regolamento sui dispositivi medici (MDR 2017/745).

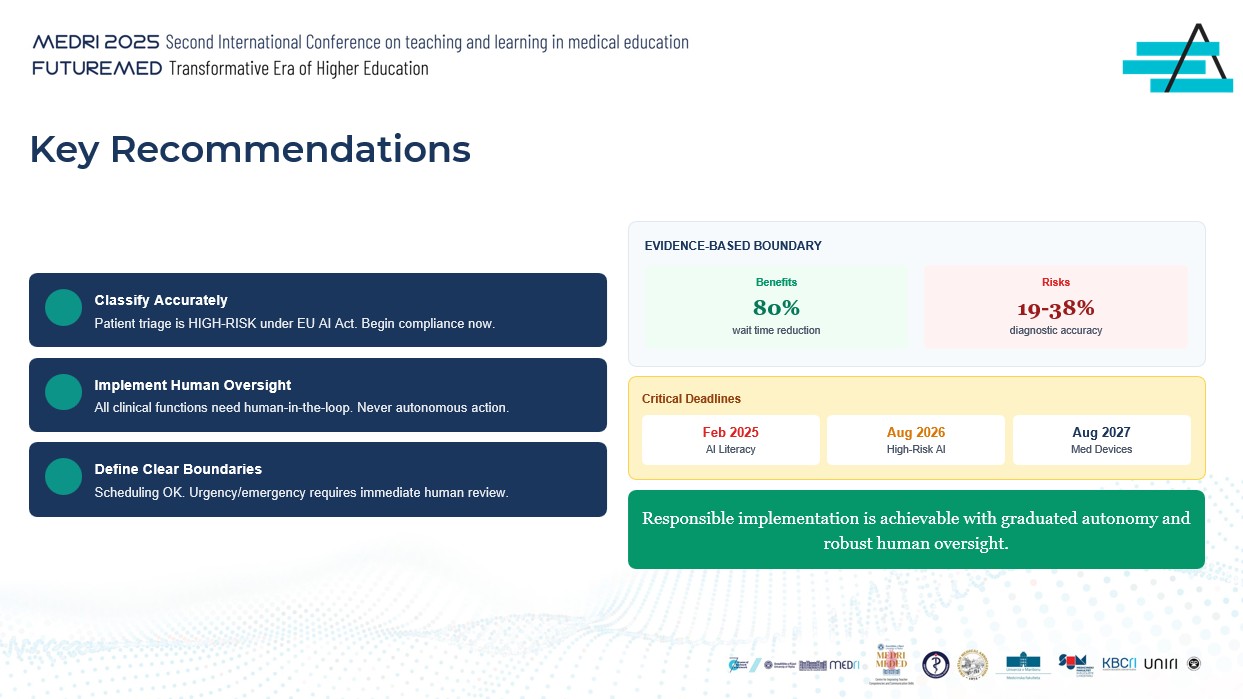

I principali termini di conformità che le istituzioni devono tenere a mente sono febbraio 2025 per la formazione all'alfabetizzazione in materia di IA, agosto 2026 per i sistemi di cui all'allegato III e agosto 2027 per i dispositivi medici. Queste scadenze non sono raccomandazioni, ma requisiti vincolanti che richiedono un'azione immediata.

Responsabilità nel sistema distribuito

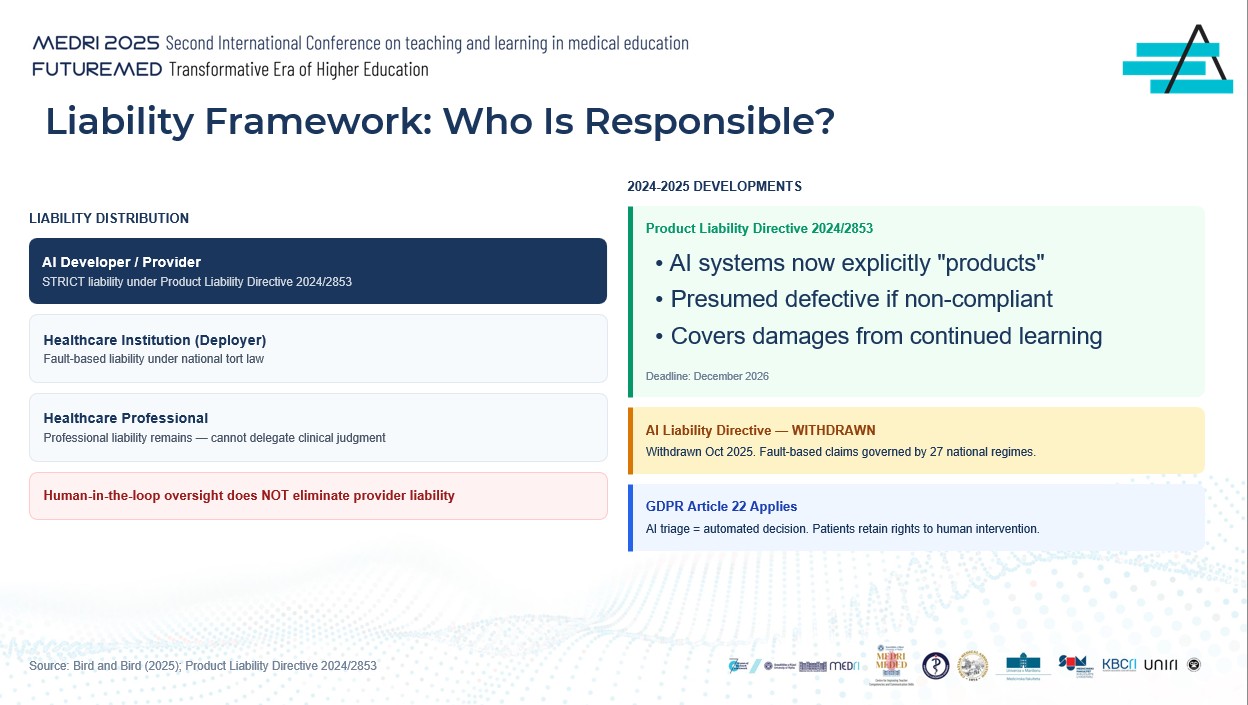

Un segmento particolarmente interessante della lezione è stato legato alla complessa distribuzione delle responsabilità tra i diversi attori nella catena di implementazione del sistema di IA. Ai sensi della nuova direttiva sulla responsabilità per danno da prodotti difettosi 2024/2853, i sistemi di IA sono ora definiti esplicitamente come "prodotti", supponendo che i sistemi non armonizzati siano difettosi. La direttiva copre anche i danni causati dall'apprendimento continuo del sistema, che è particolarmente rilevante per i moderni modelli di IA.

Gli sviluppatori e i fornitori di sistemi di IA sono soggetti a responsabilità oggettiva ai sensi della presente direttiva, mentre le istituzioni sanitarie in quanto utenti del sistema rimangono responsabili ai sensi delle leggi nazionali in materia di illeciti civili. Ciò che è particolarmente importante sottolineare è che gli operatori sanitari mantengono la responsabilità professionale e non possono delegare la valutazione clinica ai sistemi di IA. Come ha sottolineato Medved, il monitoraggio human-in-the-loop non elimina la responsabilità dei fornitori di servizi.

Inoltre, l'applicazione dell'articolo 22 del GDPR significa che il triage dell'IA rappresenta un processo decisionale automatizzato, mentre i pazienti mantengono il diritto all'intervento umano. È interessante notare che la proposta iniziale di direttiva sulla responsabilità per IA è stata ritirata nell'ottobre 2025, il che significa che le richieste di risarcimento basate su guasti sono ora attuate attraverso 27 diversi regimi nazionali.

Paradosso della sicurezza: Quando l'accuratezza non è sufficiente

Una delle parti più sorprendenti della lezione riguardava le prove cliniche sulle prestazioni del sistema di controllo dei sintomi AI. L'analisi di 48 diversi sistemi ha mostrato che la loro accuratezza nella diagnosi primaria varia tra solo 19% e 38%, mentre la precisione nel triage raggiunge tra 49% e 90%. Rispetto ai medici generici, i migliori sistemi di IA raggiungono una precisione di 70,5%Il numero medio di medici è 82,1% precisione.

Particolarmente preoccupante è il verificarsi di sottotriage, in cui i sistemi di IA non riconoscono condizioni gravi in uno su sette o dieci casi. Medved ha documentato una serie di guasti effettivi del sistema di IA, tra cui un'indagine di Stanford 2025 che ha mostrato che 20% La risposta del sistema di intelligenza artificiale contiene raccomandazioni non sicure, come proporre l'altezza del ponte alle persone con pensieri depressi. ChatGPT ha consigliato documentatamente a una persona con infezione delle vie urinarie di “bere urina”, con conseguente autoavvelenamento. Babylon Health ha mostrato pregiudizi di genere e interpretato l'attacco cardiaco come un attacco di panico, mentre uno studio pubblicato su Annals of Internal Medicine ha rilevato che ben 88% Le risposte possono essere false quando i chatbot vengono manipolati.

Quadri etici e linee guida mediche

Nel 2021 l'Organizzazione mondiale della sanità (OMS) ha pubblicato sei principi fondamentali per l'attuazione dell'IA nella salute, tra cui la protezione dell'autonomia, la promozione della sicurezza, la garanzia della trasparenza, la promozione della responsabilità, la garanzia dell'inclusività e la promozione della sostenibilità. L'aggiornamento del 2024 ha aggiunto oltre 40 raccomandazioni specifiche per i modelli linguistici di grandi dimensioni, con avvertenze specifiche in merito alla "polarizzazione dell'automazione".

Nella sua dichiarazione del 2025, l'Associazione medica mondiale utilizza il termine "intelligenza complementare" anziché "intelligenza artificiale", sottolineando che l'IA sostiene, ma non sostituisce, il giudizio umano. Il medico deve mantenere l'autorità finale su tutti i risultati dell'IA. Analogamente, nella sua dichiarazione del novembre 2024, il comitato permanente dei medici europei (CPME) afferma chiaramente che "l'IA non è stata attuata per sostituire gli operatori sanitari o ridurre l'autonomia dei pazienti" e che i medici restano liberi di decidere in merito all'uso dell'IA.

Applicando i principi bioetici classici al triage dell'IA, Medved ha spiegato che il principio di autonomia richiede che i pazienti siano informati sul sistema di IA e abbiano diritto a una valutazione basata esclusivamente sul giudizio umano. Il principio di benevolenza richiede una rigorosa convalida dell'efficienza e della sicurezza prima dell'implementazione. Il principio di non nuocere è particolarmente critico per identificare le emergenze in cui il guasto di un sistema può portare a danni immediati. Infine, il principio di giustizia richiede la convalida attraverso diverse popolazioni e la lotta al "divario digitale".

La fiducia del paziente come prerequisito fondamentale

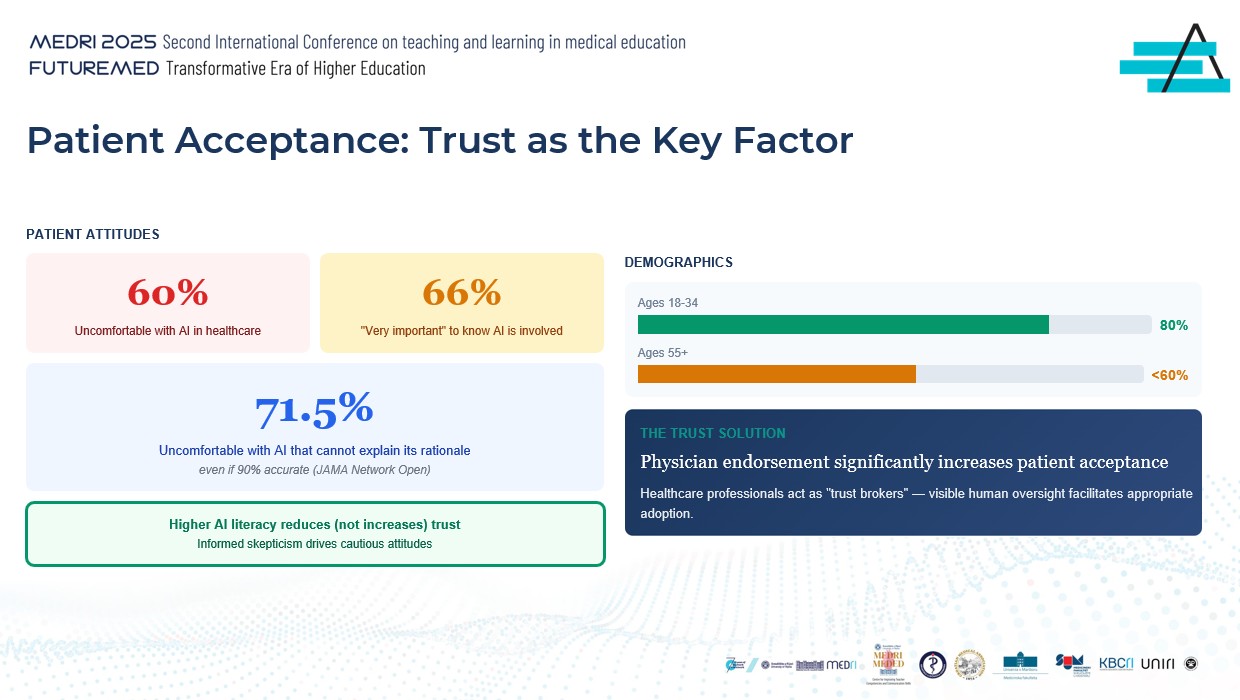

La ricerca presentata nella conferenza ha rivelato un affascinante paradosso negli atteggiamenti dei pazienti nei confronti dell'IA nel settore sanitario. Fino a 60% i pazienti si sentono a disagio con l'uso dell'IA nell'assistenza sanitaria, mentre 66% ritiene "molto importante" sapere se l'IA è coinvolta nella loro assistenza. Forse il fatto più preoccupante è che 71.5% i pazienti si sentono a disagio con un sistema di intelligenza artificiale che non può spiegare la sua logica, anche se questo sistema raggiunge 90% precisione.

L'analisi demografica mostra che le generazioni più giovani, in particolare tra i 18 e i 34 anni, mostrano una maggiore fiducia nell'IA (circa 80 anni).%), mentre le generazioni più anziane di età superiore ai 55 anni mostrano meno di 60 anni% accettazione. È interessante notare che una maggiore alfabetizzazione all'IA non aumenta la fiducia, ma in realtà la riduce, indicando che lo scetticismo informato porta ad atteggiamenti cauti.

La soluzione chiave evidenziata da Medved riguarda il ruolo dei medici come "facilitatori della fiducia". La conferma e la raccomandazione di un professionista sanitario aumenta significativamente l'accettazione del sistema di IA da parte dei pazienti. Il controllo umano visibile agisce come un meccanismo che facilita l'adozione appropriata della tecnologia.

Un modello di autonomia graduale come soluzione pratica

In risposta alle complesse sfide poste dagli agenti di conversione dell'IA, la conferenza è stata presentata dall'innovativo "Graduated Autonomy Framework", che allinea l'autonomia del sistema di IA al livello di rischio clinico. Questo modello riconosce che il confine tra i diversi livelli di autonomia determina la classificazione normativa e la distribuzione delle responsabilità.

Per le funzioni a rischio più basso, come fornire informazioni e rispondere alle domande più frequenti, viene utilizzato il modello human-on-the-loop, in cui la supervisione umana è disponibile ma non obbligatoria per ogni transazione. Lo stesso modello si applica agli appuntamenti di base. Per il rischio medio, come un questionario sui sintomi che raccoglie dati, si utilizza "human-in-the-loop", in cui la revisione umana diventa parte integrante del processo.

Nelle funzioni ad alto rischio, come le valutazioni di emergenza che richiedono una definizione delle priorità, sono necessarie approvazioni umane esplicite prima di intraprendere qualsiasi azione. Infine, per funzioni critiche come il riconoscimento di emergenza, viene utilizzato un modello human-in-command, in cui il sistema di IA può allertare solo il personale che mantiene il pieno controllo sulle decisioni.

Dimostrazione pratica: Assistente AI per Policlinico

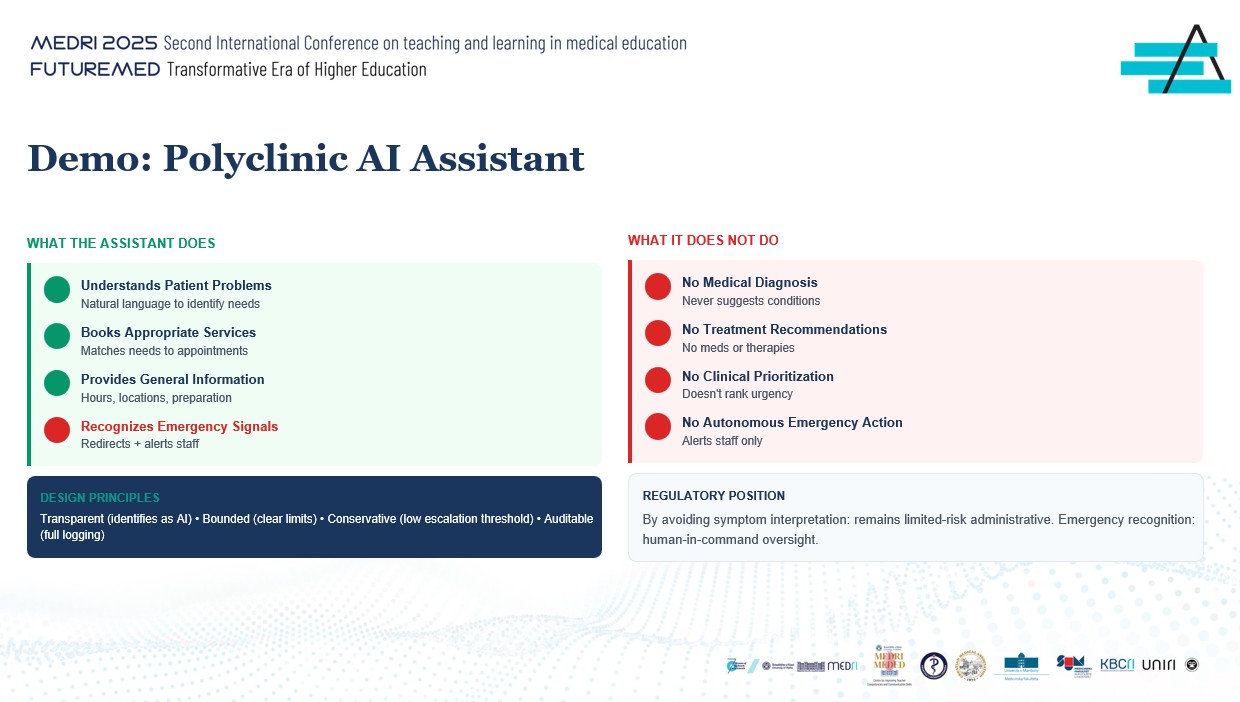

Per illustrare l'applicazione dei principi teorici, Medved ha presentato una dimostrazione di un assistente AI progettato per un policlinico. Questo sistema è progettato secondo chiari principi di trasparenza, limitazione, conservatorismo e auditing.

L'assistente può comprendere i problemi dei pazienti usando il linguaggio naturale per identificare le esigenze, programmare i servizi appropriati abbinando le esigenze agli appuntamenti disponibili, fornire informazioni generali sull'orario di lavoro, sui luoghi e sulla preparazione per gli esami e identificare i segnali di emergenza e reindirizzare la comunicazione mentre avvisa il personale.

Ciò che l'assistente non fa esplicitamente è importante quanto ciò che fa. Il sistema non propone mai diagnosi mediche o suggerisce condizioni specifiche. Non formula raccomandazioni sul trattamento, non propone farmaci o terapie. Non conduce la prioritizzazione clinica o classifica l'urgenza dei casi. Ancora più importante, non intraprende azioni autonome in caso di emergenza, ma avverte solo il personale.

Questo design consente al sistema di rimanere nella categoria del rischio amministrativo limitato evitando l'interpretazione dei sintomi, mentre per il riconoscimento delle emergenze applica il monitoraggio umano-in-comando, che garantisce la conformità normativa e la sicurezza clinica.

La via da seguire: Raccomandazioni per l'attuazione

Medved ha concluso la conferenza con tre raccomandazioni chiave per le istituzioni sanitarie che considerano l'implementazione di agenti di conversione AI. La prima raccomandazione riguarda la corretta classificazione della funzionalità ai sensi della normativa dell'UE sull'IA, in base alla quale il triage dei pazienti deve essere trattato come un'applicazione ad alto rischio e avviare immediatamente il processo di conformità.

La seconda raccomandazione sottolinea l'implementazione di una robusta sorveglianza umana per tutte le funzioni cliniche, utilizzando un modello human-in-the-loop in cui non deve mai verificarsi un'azione completamente autonoma. La terza raccomandazione richiede la definizione di chiari confini funzionali in cui la programmazione è accettabile, ma la valutazione dell'urgenza e delle emergenze richiede sempre una revisione umana immediata.

I principali calendari da seguire per le istituzioni sono febbraio 2025 per la formazione all'alfabetizzazione in materia di IA, agosto 2026 per i sistemi di cui all'allegato III e agosto 2027 per i dispositivi medici. Come ha sottolineato Medved, un'attuazione responsabile è realizzabile attraverso l'applicazione di un modello di autonomia graduale e di una solida supervisione umana.

La conferenza si è conclusa con un messaggio forte: "Gli agenti di conversione dell'IA offrono un valore reale, ma un'attuazione responsabile richiede che li trattiamo come strumenti che integrano e non sostituiscono mai la pratica clinica". Questo messaggio è in sintonia con la missione di EDIH ADRIA di sostenere una trasformazione digitale innovativa e responsabile, stabilisce norme europee nell'attuazione delle tecnologie di IA e contribuisce alla creazione di un sistema sanitario che combini il progresso tecnologico con l'assistenza umana.